本帖最后由 oyoy8629 于 2009-10-13 14:34 编辑

本人刚刚开始学习SS.

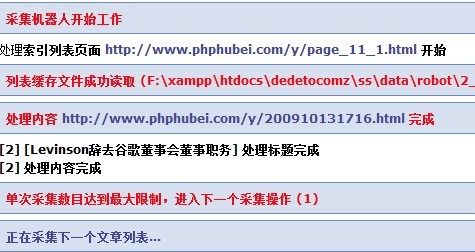

在采集时候遇到很多问题非常烦躁,特别是采集的时候总是失败.

后来无意中发现了boss发的帖子关于supesite7采集器的刚采集就结束的修改方案

中

.发现.SS的采集是使用函数file_get_contents,这个东东,在采集读取内容时候.必须网速要非常好才可以

所以,我就换成了curl的方式采集

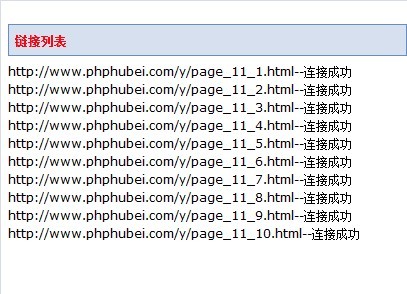

列表采集

在/admin/admin_robots.php中 1957行增加- function fileget($url){

- $curl = curl_init();

- curl_setopt($curl, CURLOPT_URL, $url);

- curl_setopt($curl, CURLOPT_USERAGENT, 'Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 6.0; SLCC1; )');

- curl_setopt($curl, CURLOPT_HEADER, 0);

- curl_setopt($curl, CURLOPT_RETURNTRANSFER, 1);

- curl_setopt($curl, CURLOPT_COOKIE, 'phphubei');

- $tmpInfo = curl_exec($curl);

- curl_close($curl);

- return $tmpInfo;

- }

- if(!empty($url)) {

- if(function_exists('file_get_contents')) {

- @$text = file_get_contents($url);

- } else {

- @$carr = file($url);

- if(!empty($carr) && is_array($carr)) {

- $text = implode('',$carr);

- }

- }

- }

- if(!empty($url)) {

- @$text = fileget($url);

- }

这里注意............

服务器默认是不支持curl的

需要php.ini开启扩展.

开启扩展方法是

//1.在php.ini中去掉extension=php_curl.dll前面的分号.

//若不成功复制 php_curl.dll

// libeay32.dll

// ssleay32.dll

//到 C:\WINDOWS\System32下

改完了主意重启apache.

请注意备份你的admin_robots.php以防不测.

下面是改好的文件

admin_robots.rar

(17.55 KB, 下载次数: 228)

admin_robots.rar

(17.55 KB, 下载次数: 228)

http://bbs.phphubei.com/thread-4600-1-1.html

|